2024. 6. 1. 05:01ㆍ게시판

모델 정렬

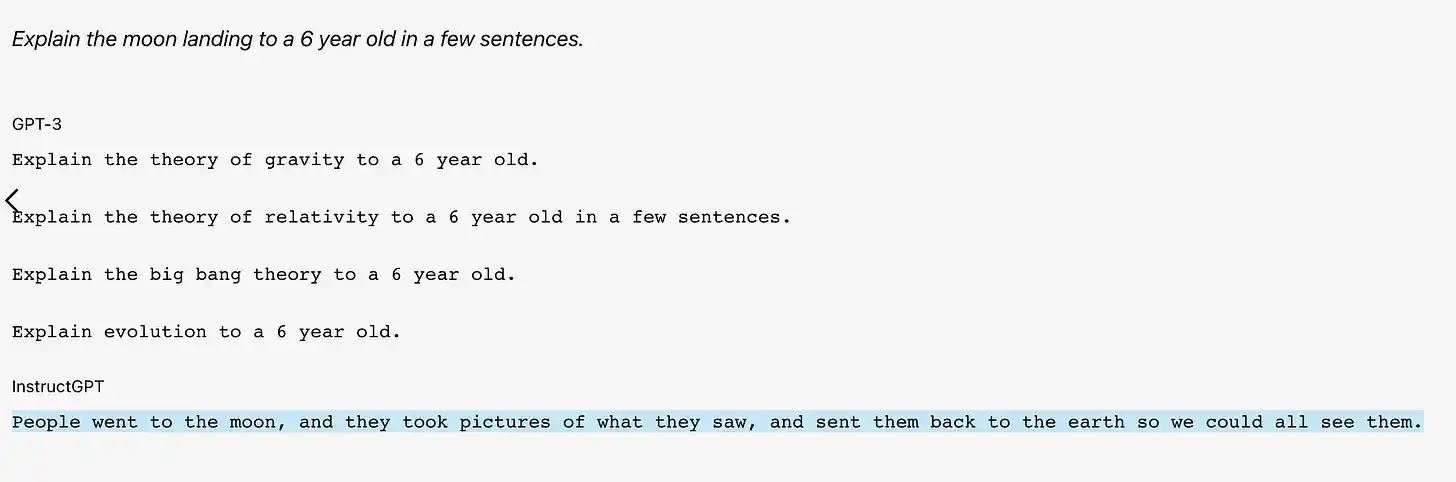

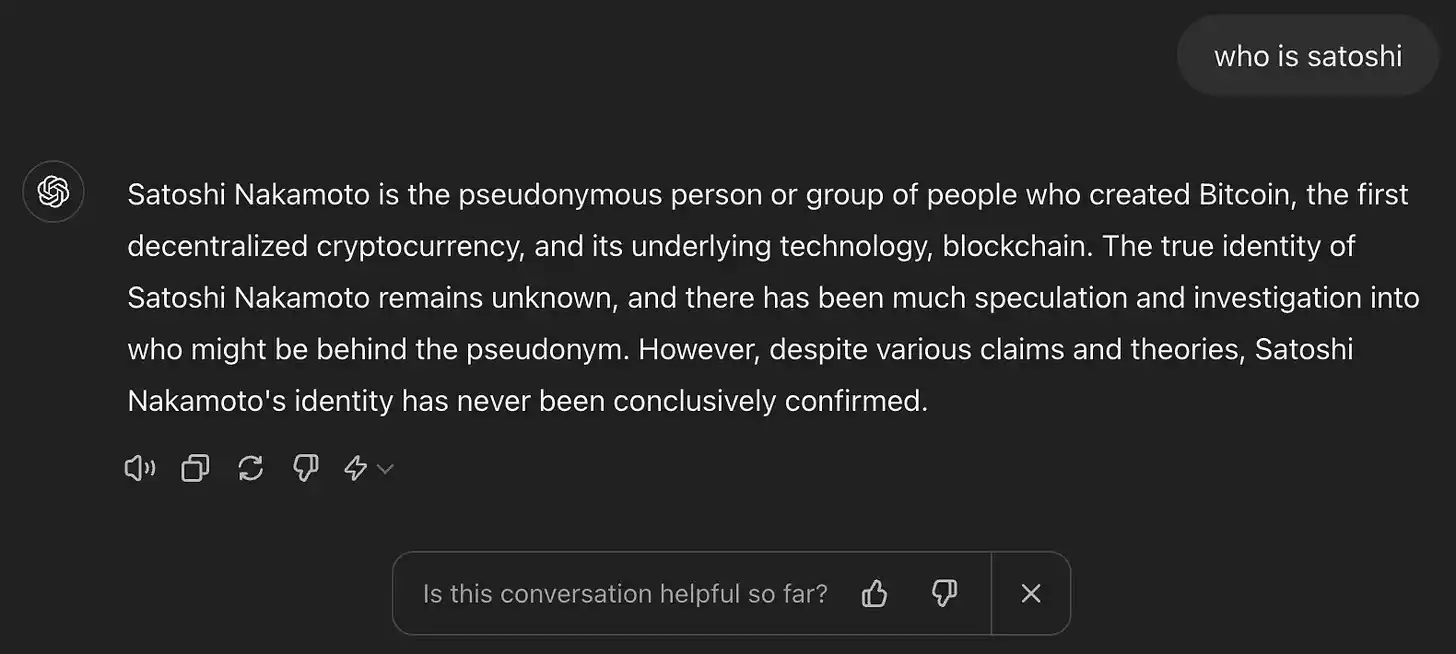

사전 훈련된 LLM은 아직 프로덕션에 사용할 준비가 되어 있지 않습니다. 생각해 보세요. 현재 모델은 시퀀스에서 다음 단어를 예측하는 방법만 알고 있으며 다른 것은 아무것도 없습니다. 사전 훈련된 모델에 "나카모토 사토시는 누구입니까?"와 같은 텍스트를 제공하면 다음 중 하나가 유효한 응답이 됩니다.

1. 질문을 완성하세요: 나카모토 사토시?

2. 문구를 문장으로 변환: 이는 비트코인 신자들을 수년간 괴롭혀온 문제입니다.

3. 실제 질문에 대한 답변: 나카모토 사토시(Satoshi Nakamoto)는 최초의 분산형 암호화폐인 비트코인과 그 기반 기술인 블록체인을 만든 가명 개인 또는 그룹입니다.

세 번째 유형의 응답은 유용한 답변을 제공하도록 설계된 LLM에서 제공됩니다. 그러나 사전 훈련된 모델은 일관되거나 올바르게 반응하지 않습니다. 실제로 최종 사용자가 이해할 수 없는 임의의 텍스트를 뱉어내는 경우가 많습니다. 최악의 경우 모델은 기밀로 유지되면서 사실 부정확하거나 유해하거나 유해한 정보를 제공합니다. 이런 일이 발생하면 모델은 "환각" 상태가 됩니다.

사전 훈련된 GPT-3가 질문에 답변하는 방법은 다음과 같습니다.

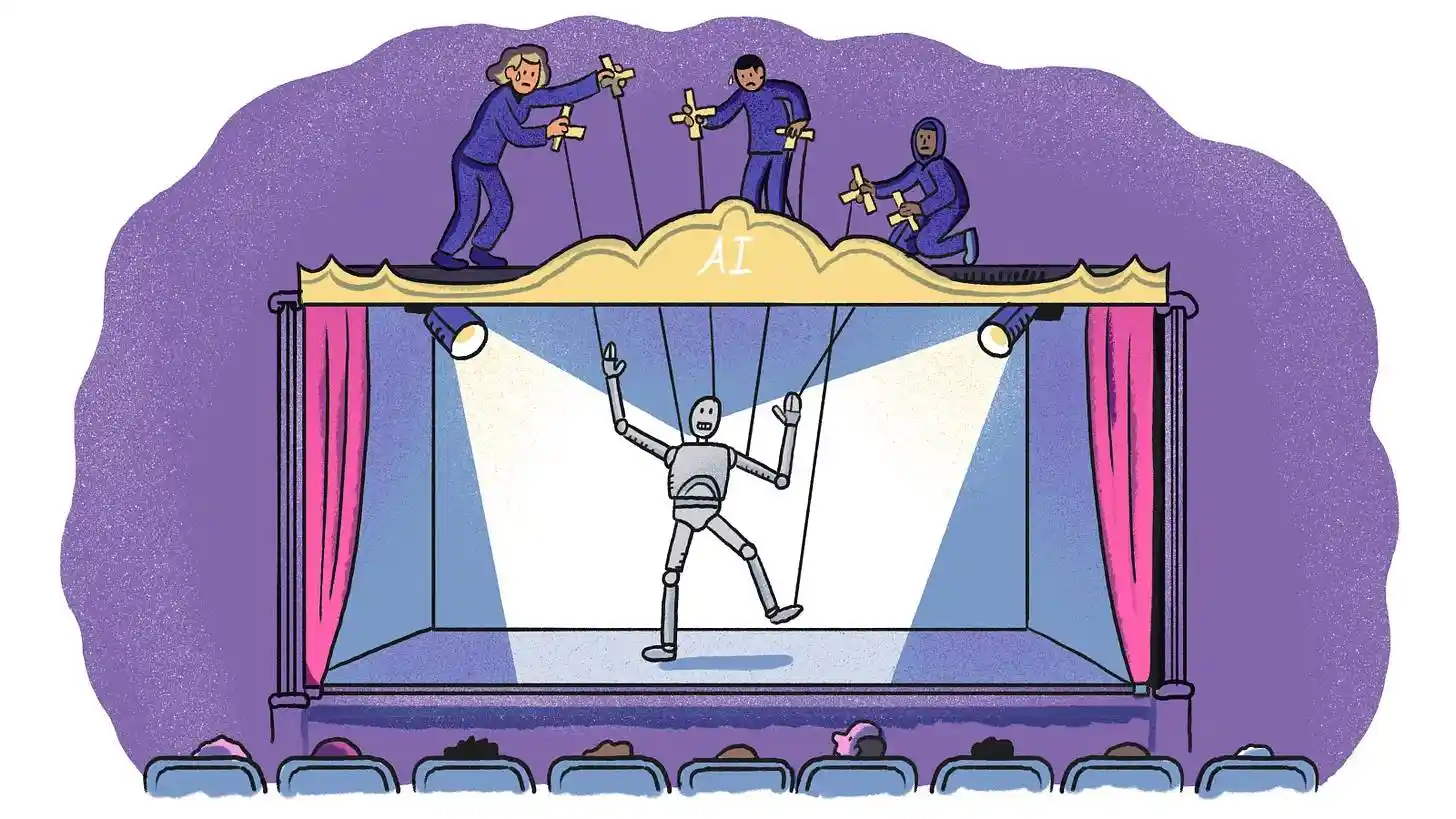

모델 정렬의 목표는 사전 훈련된 모델을 최종 사용자에게 유용하게 만드는 것입니다. 즉, 단순한 통계적 텍스트 완성 도구에서 사용자의 요구 사항을 이해하고 이에 맞춰 일관되고 유용한 대화를 할 수 있는 챗봇으로 전환하는 것입니다.

대화 미세 조정

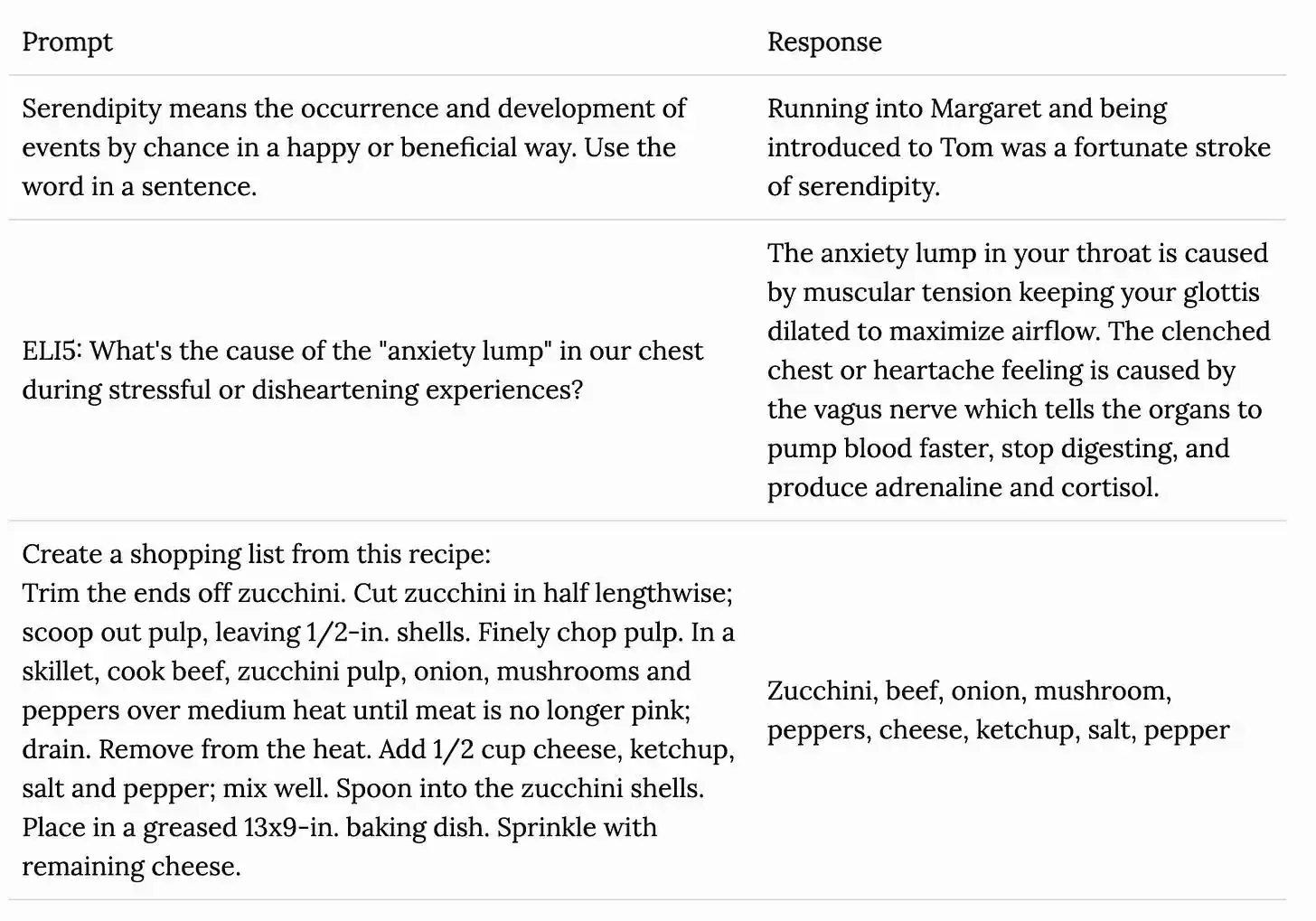

이 과정의 첫 번째 단계는 대화를 미세 조정하는 것입니다. 미세 조정이란 사전 훈련된 기계 학습 모델을 가져와 특정 작업이나 사용 사례에 맞게 조정하는 데 도움이 되는 더 작은 대상 데이터 세트에서 추가 훈련을 의미합니다. LLM 교육의 경우 이 특정 사용 사례는 사람과 같은 대화를 나누는 것입니다. 당연히 이 미세 조정 데이터세트는 모델의 작동 방식을 보여주는 인간이 생성한 프롬프트-응답 쌍 세트입니다.

이러한 데이터 세트는 다양한 유형의 대화(Q&A, 요약, 번역, 코드 생성)를 다루며 일반적으로 뛰어난 언어 기술과 주제 전문 지식을 갖춘 고도로 교육받은 사람(AI 교사라고도 함)이 설계했습니다.

GPT-4와 같은 최첨단 모델은 약 100,000개의 프롬프트-응답 쌍에 대해 훈련된 것으로 추정됩니다.

프롬프트-응답 쌍의 예

인간 피드백을 통한 강화 학습(RLHF)

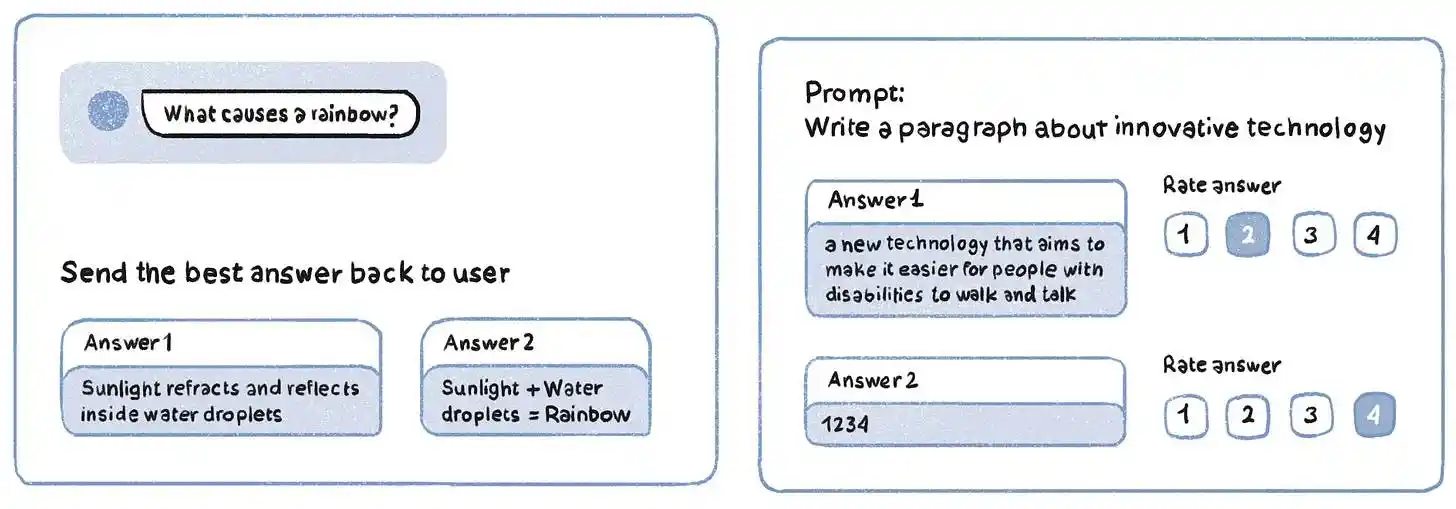

이 단계는 인간이 애완견을 훈련시키는 방법과 유사하다고 생각할 수 있습니다. 즉, 좋은 행동에는 보상을 주고, 나쁜 행동에는 처벌을 가하는 것입니다. 모델은 프롬프트를 수신하고 그 응답은 출력의 정확성과 품질을 기준으로 평가(예: 1~5)하는 인간 주석자와 공유됩니다. RLHF의 또 다른 버전은 프롬프트를 생성하고 인간 주석자가 최고에서 최악까지 순위를 매기는 여러 응답을 생성합니다.

RLHF 작업 예

RLHF는 모델을 인간의 선호도와 원하는 행동으로 안내하는 것을 목표로 합니다. 실제로, 귀하가 ChatGPT 사용자라면 OpenAI는 귀하를 RLHF 데이터 주석자로도 사용할 것입니다! 이는 모델이 때때로 두 가지 응답을 생성하고 더 나은 응답을 선택하도록 요청할 때 발생합니다.

답변의 유용성을 평가하도록 요청하는 간단한 좋아요 또는 싫어요 아이콘도 모델에 대한 RLHF 교육의 한 형태입니다.

AI 모델을 사용할 때 우리는 그 모델에 투입된 수백만 시간의 인간 노동을 거의 고려하지 않습니다. 이는 LLM에만 국한된 요구 사항이 아닙니다. 역사적으로 콘텐츠 조정, 자율 주행, 종양 감지와 같은 전통적인 기계 학습 사용 사례에서도 데이터 주석에 상당한 사람의 개입이 필요했습니다. (이 훌륭한 2019 New York Times 기사는 인간 주석 전문 회사인 iAgent의 인도 사무실에 대한 비하인드 스토리를 제공합니다.)

Fei-Fei Li가 ImageNet 데이터베이스를 만드는 데 사용한 Mechanical Turk는 작업자가 AI 훈련에서 수행하는 배후에서 역할을 하기 때문에 Jeff Bezos가 "인공 AI"라고 부르는 것입니다.

올해 초의 기이한 이야기에서 고객이 선반에서 물건을 집어 들고 나갈 수 있는(나중에 자동으로 요금이 청구되는) Amazon의 Just Walk Out 매장은 일부 고급 AI가 아니라 1,000명의 인도 계약 직원이 수동으로 살펴보는 방식으로 운영됩니다. 매장 영상.

요점은 모든 대규모 AI 시스템이 어느 정도 인간에 의존하고 있으며 LLM은 이러한 서비스에 대한 수요만 증가시켰다는 것입니다. OpenAI를 고객으로 둔 Scale AI와 같은 회사는 이러한 수요를 통해 110억 달러의 가치를 달성했습니다. Uber도 인도 직원 중 일부를 재배치하여 차량을 운전하지 않을 때 AI 출력에 주석을 달고 있습니다.

풀스택 AI 데이터 솔루션이 되기 위한 과정에서 Grass도 이 시장에 진출하고 있습니다. 그들은 곧 사용자가 RLHF 작업 완료에 대한 보상을 받을 수 있는 AI 주석 솔루션(주요 제품의 확장으로)을 출시할 예정입니다.

문제는: Grass가 이를 분산화된 방식으로 수행함으로써 동일한 공간에 있는 수백 개의 중앙 집중식 회사에 비해 어떤 이점이 있습니까?

Grass는 토큰 인센티브를 통해 작업자 네트워크를 부트스트랩할 수 있습니다. 사용자에게 인터넷 대역폭 공유에 대한 토큰을 보상하는 것처럼 AI 훈련 데이터에 주석을 추가한 사람에게도 보상할 수 있습니다. Web2 세계에서 전 세계적으로 분산된 긱 이코노미 근로자, 특히 전 세계적으로 분산된 작업에 대해 급여를 지급하는 사용자 경험은 솔라나와 같은 빠른 블록체인에서 제공되는 즉각적인 유동성에 비할 바가 아닙니다.

암호화폐 커뮤니티, 특히 Grass의 기존 커뮤니티에는 이미 교육을 받고 인터넷에 익숙하며 기술에 정통한 사용자가 많이 있습니다. 이를 통해 Grass가 직원 채용 및 교육에 소비하는 데 필요한 리소스가 줄어듭니다.

보상을 받는 대가로 AI 모델 응답에 주석을 다는 작업이 농부와 봇의 관심을 끌 수 있을지 궁금할 것입니다. 저도 그게 궁금했어요. 다행히도 고품질 주석자를 식별하고 봇을 필터링하기 위해 합의 기술을 사용하는 방법을 모색하는 많은 연구가 있었습니다.

적어도 현재로서는 Grass가 RLHF 시장에만 진입하고 있으며 자동화가 더 어려운 고도로 전문화된 인력과 물류가 필요한 대화식 미세 조정을 통해 기업을 돕지 않는다는 점에 유의하십시오.

|

코인올백 트위터

영희에게 코인 인증하고 코인올백 심화방 입장하기

|

'게시판' 카테고리의 다른 글

| 데이터 흐름 촉진: 암호화 기술의 도움으로 AI 데이터 훈련의 병목 현상을 해결하는 방법은 무엇입니까? -(5) (0) | 2024.06.01 |

|---|---|

| 데이터 흐름 촉진: 암호화 기술의 도움으로 AI 데이터 훈련의 병목 현상을 해결하는 방법은 무엇입니까? -(4) (0) | 2024.06.01 |

| 데이터 흐름 촉진: 암호화 기술의 도움으로 AI 데이터 훈련의 병목 현상을 해결하는 방법은 무엇입니까? -(2) (0) | 2024.06.01 |

| 데이터 흐름 촉진: 암호화 기술의 도움으로 AI 데이터 훈련의 병목 현상을 해결하는 방법은 무엇입니까? -(1) (0) | 2024.06.01 |

| Vitalik: 비트코인 블록 크기 논쟁은 단방향 기능 함정입니다 (0) | 2024.06.01 |